마이크로 프로세서는 집적회로 기술이 발전함에 따라 보다 더 다양하고 복합적인 프로세서를 단일 칩으로 제조할 수 있게 되었습니다. 이는 데이터 객체의 크기가 커지게 되면서 자연스럽게 생긴 현상입니다. 칩에서 더 많은 트랜지스터를 허용함으로써 워드 크기가 4비트 및 8비트 워드부터 시작해, 현재는 64비트 워드까지 증가할 수 있게 되었습니다. 프로세서의 아키텍처에 추가 기능이 지속적으로 추가되고 있으며, 보다 더 많은 온칩 형태의 레지스터가 프로그램을 가속화하고 복잡한 명령을 사용함에 있어 보다 더 작은 프로그램을 구동할 수 있게 되었습니다.

예를 들어 보겠습니다. 부동의 소수점 산술은 종종 8 비트 마이크로 프로세서에서는 사용할 수 없는 형태의 알고리즘 형태를 나타내고 있었습니다만, 이와 같은 연산을 처리하기 위해서는 소프트웨어의 구동이 필수적이었습니다. 이를 부동 소수점 단위의 통합과 별도의 집적 회로를 사용하고 마찬가지로 이와 동일한 마이크로 프로세서 칩의 일부를 적용하여 부동 소수점 계산을 가속화 할 수 있었습니다.

경우에 따라서, 실무자들은 집적 회로의 물리적 한계로 인한 비트 슬라이스 방식이 필요하기도 하였습니다. 비트 슬라이싱 (Bit Slicing)으로 불리는 이 기술은 워드의 길이를 증가시키기 위해 작은 비트 폭의 프로세서 모듈로부터 프로세서를 구성하는 기술을 뜻합니다. 이론적으로 비트 슬라이싱은 임의의 n 비트 CPU를 만들게 됩니다. 이러한 각 구성 요소의 모듈은 하나의 비트 필드 또는 피연산자의 '슬라이스'를 처리하게 됩니다. 그룹화 된 프로세싱 컴포넌트는 특정 소프트웨어 설계의 선택된 전체 워드의 길이를 처리하는 능력을 가지게 됩니다. 최근에는 가장 상위 단계의 ALU에 사용된 양자 시스템 및 소프트웨어 기술로서 사용되어 지고 있습니다.

이와 같은 방식으로 비트 슬라이싱을 적용하여 하나의 집적 회로에서 모든 종류의 긴 워드를 일괄적으로 처리하는 대신, 각 데이터 워드의 병렬 처리 된 서브 세트로 여러 회로를 각각 처리할 수 있게 되었습니다. 예를 들어 보겠습니다. 각 슬라이스 내에서 캐리 및 오버플로우를 처리하기 위해 추가적인 논의가 필요한 경우가 많았습니다. 하지만 이를 결과적으로는 각각의 4 비트 용량에 달하는 집적 회로를 사용하는 것으로 32비트를 워드 처리할 수 있는 시스템이 탄생하게 된 것입니다. 이와 같이 하나의 칩에 많은 숫자의 트랜지스터를 배치 할 수 있게 됨으로 인해서 프로세서와 동일한 규격의 메모리를 통합할 수 있게 되었습니다.

이러한 CPU의 캐시 메모리는 Off 칩 메모리보다 월등히 빠른 연산 처리 속도의 빠른 엑세스라는 이점이 있었으며, 다수의 많은 응용 프로그램에서 시스템의 처리 속도를 높여주는 계기를 마련해 주었습니다. 프로세서의 클럭 주파수는 외부 메모리 속도보다 빠르게 증가하게되므로 이러한 프로세서가 느린 속도의 외부 메모리로 지연되지 않게 되면서 일정 수준의 캐시 메모리가 필요해 지게 되었습니다.

마이크로 프로세서는 워드의 크기를 기준으로 하여 다양한 형태의 애플리케이션에 대해 고난이도의 연산을 효율적으로 처리할 수 있으며 이는 다양한 형태의 연산을 복잡성을 기준으로 한 측정 기준에 의해 동시 다발적으로 처리할 수 있게 될 것입니다. 워드의 크기가 길어질수록 프로세서의 각 클록 사이클에서 더 많은 계산을 수행할 수 있지만, 대기 및 작동 전력 소비가 높아지는 현상으로 이에 걸맞게 물리적으로 큰 집적 회로 역시 필요하게 되었습니다.

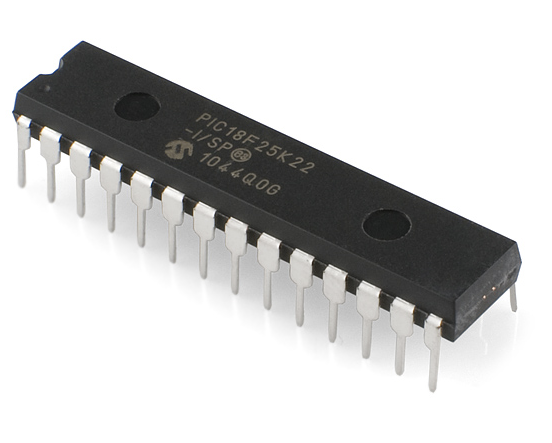

4 비트 혹은 8 비트, 그리고 12 비트의 프로세서는 임베디드 시스템을 운영하는 마이크로 컨트롤러에 널리 통합되어 사용되어지게 되었습니다. 시스템에서 대량의 데이터를 처리하거나 보다 유연한 사용자 인터페이스가 필요하게 되는 경우, 16 비트 혹은 32비트, 그리고 64 비트 프로세서가 사용되어 지게 됩니다. 초 저전력 전자 장치가 필요한 칩 또는 마이크로 컨트롤러 애플리케이션의 시스템을 위해 실무자는 32 비트 프로세서에서부터 8 비트 또는 16 비트 프로세서를 선택할 수 있게 되었습니다.

전통적으로, 컴퓨터와 관련되지 않은 수천 개의 항목에는 마이크로 프로세서가 폼되어지게 됩니다. 여기에는 크고 작은 가전 제품을 포함하여 자동차 및 자동차의 액세서리와 장비, 혹은 전자적 구조를 가지고 있는 도구 및 테스트 장비, 전기 회로 장치 등의 구성 요소가 모두 포함되어 지게 됩니다. 이와 같이 프로그래밍이 필요한 전자적 제어 장치의 필요로 인하여 마이크로 프로세서로 가능한 결과를 달성하기 위해 복잡한 난이도의 연산을 보다 효율적으로 처리하기 위한 알고리즘 구현이 필요해 지게 된것입니다.

'컴퓨터 공부' 카테고리의 다른 글

| 마이크로 프로세서의 역사와 기원 (0) | 2020.06.30 |

|---|---|

| 컴퓨터의 연산 알고리즘에 대한 개념 이해. (0) | 2020.06.29 |

| 컴퓨터 과학의 역사로 알아보는 컴퓨터 공학과의 차이. (0) | 2020.06.23 |

| 이론 컴퓨터 공학의 정의. (0) | 2020.06.19 |

| 컴퓨터 공학의 역사에 대해서. (0) | 2020.06.19 |